Hallo Freunde! Die Model-Releases lassen aktuell nicht nach. Nach Grok 3 und Claude Sonnet 3.7 widmen wir uns heute OpenAIs neustem Model GPT-4.5. Und ihr könnt sogar interaktiv testen, wie ihr es im Vergleich zum Vorgänger 4o findet!

Und wenn der Newsletter ausgelesen ist, aber ihr noch mehr Durst auf KI-Infos habt, legen wir euch heute wärmstens Andrej Karpathy’s neustes Video zu LLMs ans Herz.

Und jetzt rein in die Themen!

Peanuts für heute:

🤷♂️ GPT-4.5 - Ist OpenAI’s neustes Modell eine Enttäuschung?

🔍 Deep Research von ChatGPT nun für Plus-User verfügbar

🛠 Diese Voice-KI Demo ist der Wahnsinn!

Anzeige

KI im Unternehmen: Schluss mit Schatten-KI, Sicherheit geht vor!

Hast du dich schon einmal gefragt, wie du Künstliche Intelligenz sicher in deinem Unternehmen einsetzen kannst? Die rasante Entwicklung von KI-Technologien bringt nicht nur technische, sondern auch wichtige Datenschutz- und Sicherheitsfragen mit sich.

Ein oft unterschätztes Risiko: Was passiert mit den Informationen, die Mitarbeitende in KI-Tools eingeben, die privat “organisiert” wurden? Viele Anbieter nutzen diese Daten möglicherweise für das Training ihrer KI-Modelle – und das könnte sensible Firmeninformationen gefährden.

Doch es gibt Lösungen: Plattformen wie ChatGPT bieten in ihren Einstellungen die Möglichkeit, der Nutzung dieser Daten zu widersprechen.

Welche Datenschutzbestimmungen beim Einsatz von KI-Tools besonders relevant sind und worauf Unternehmen achten sollten, erfährst du ausführlich im Modul „Datenschutz & KI“ von unserem Partner Herdt. Dieses Modul ist für Unternehmen jeder Größe von Bedeutung. Wenn das für dich interessant klingt - schau doch mal rein:

🥜 Die größte Nuss:

🤷♂️ GPT-4.5 - Ist OpenAI’s neustes Modell eine Enttäuschung?

Nach den medial mit viel Fanfaren begleiteten Releases von Grok 3 und Claude 3.7 (wir berichteten hier und hier), war es für OpenAI Zeit, nachzuziehen. Das taten sie letzten Donnerstag mit der Veröffentlichung des neuen Modells GPT-4.5.

Die Reaktionen bisher sind aber eher: meh. Ob die Zurückhaltung gerechtfertigt ist, und was 4.5 trotzdem zu einem sehr spannenden Release macht, schauen wir uns heute an.

Kurz zu den Fakten:

GPT-4.5 ist OpenAI’s neuestes Sprachmodell

GPT-4.5 ist kein Reasoning Modell, dass auf einen strukturierten Denkprozess trainiert ist (vgl. o1, o3 oder DeepSeek R1), sondern ein klassisches LLM

GPT-4.5 zeigt keine oder nur geringe Verbesserungen in typischen Benchmarks, OpenAI betont aber, das Modell sei v.a. qualitativ besser und besitze eine höhere Emotionale Intelligenz als vorherige Modelle

Brechen wir mal runter, was das bedeutet: GPT-4.5 sollte man also als klaren Nachfolger der bisherigen klassischen Modelle, die v.a. hinter ChatGPT stehen, sehen. Das heißt: Es ist sehr gut darin, menschlich klingende Antworten zu geben aber es ist nicht so geeignet für Aufgaben, bei denen ein tieferes Nachdenken zu einem besseren Ergebnis führt, wie z.B. Mathematik oder Code-Generierung.

4.5 ist das wohl bisher größte Modell, das OpenAI je trainiert hat, mit Abstand. Laut Andrej Karpathy wurde für das Pretraining des Modells die 10-fache Rechenleistung im Vergleich zum Pretraining von GPT-4 genutzt.

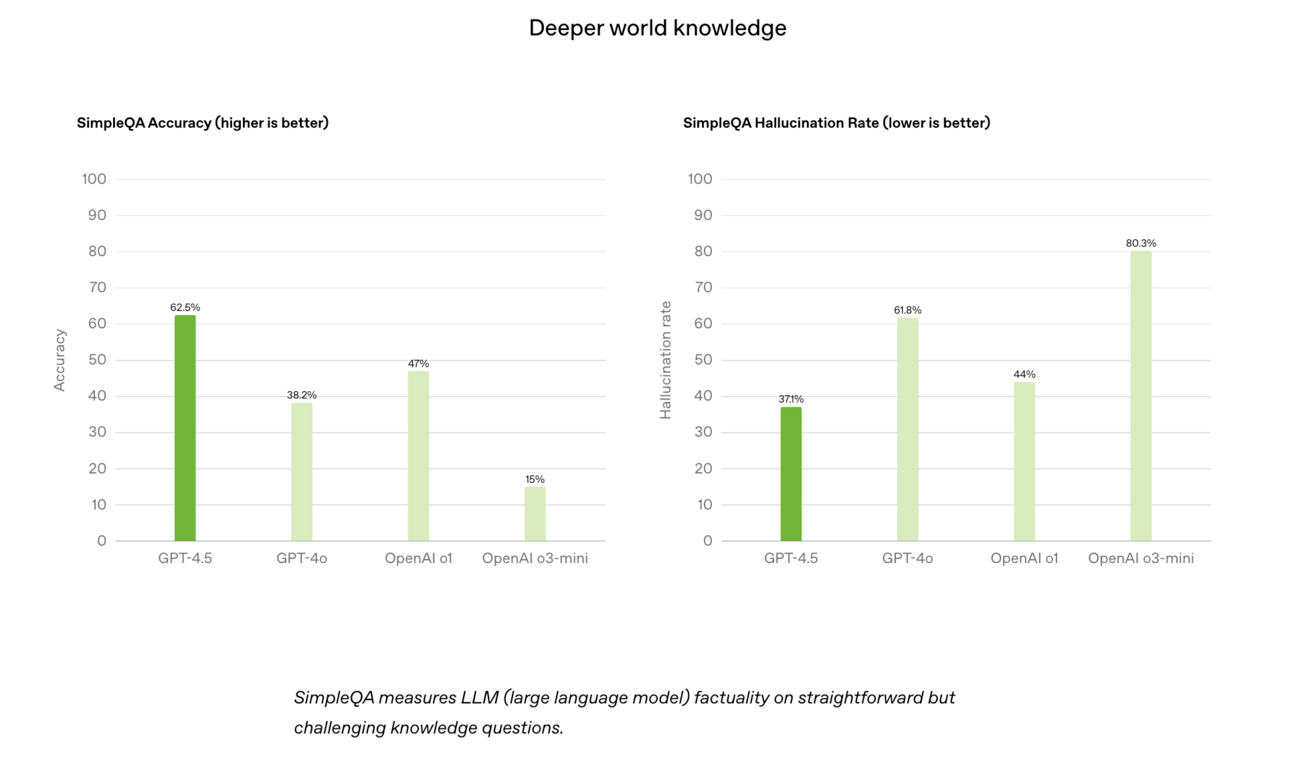

GPT-4.5 hat laut OpenAI ein “deeper world model”, also ein breiteres allgemeines Verständnis der Realität. Teil des Schlüssels, dieses zu erzeugen war wohl, das Modell auf Basis von synthetischen Daten zu trainieren, die von kleineren Modellen generiert wurden.

Dieser Ansatz ist nicht neu, aber es ist sehr spannend zu hören, dass er genau so jetzt tatsächlich für das Training neuer großer Modelle genutzt wird, da dieser Ansatz einen Weg aufzeigt, wie die Skalierung von KI-Modellen auch weiterhin gelingen kann, wenn einem die eigentlichen “echten” Trainingsdaten (nämlich jeglicher Inhalt des gesamten Internets) ausgehen.

Was kann GPT-4.5 besonders gut?

Wozu dieses breitere Weltmodell u.a. führt?

Geringere Halluzinationen

Höhere Genauigkeit der Antworten (von Menschen bewertet)

Hierbei sei natürlich angemerkt, der Benchmark SimpleQA, den OpenAI zur Beurteilung dieser Metriken nutzt, ist ein hauseigener Benchmark, hier werden nur die eigenen Modelle verglichen, und wer uns regelmäßig liest, weiß ja, dass wir Benchmarks ggü. generell oft kritisch sind.

In seiner Ankündigung zu GPT-4.5 betont OpenAI vor allem, dass das Modell in seinen Antworten mehr Nuance und mehr emotionale Intelligenz zeige. Und laut den eigenen Test präferierten Testerinnen und Tester die Antworten im Vergleich mit 4o sowohl in den Bereichen der alltäglichen Fragen, als auch im beruflichen Kontext, sowie bei Kreativ-Tasks.

Andrej Karpathy hat hierzu ein spannendes eigenes Experiment durchgeführt und seine Twitter Community, Antworten der Modelle, blind bewerten lassen.

Das Interessante dabei: Hier wurde das Vorgängermodell 4.0 in 4/5 Fällen bevorzugt. Karpathy selbst sagt jedoch, er bevorzuge tatsächlich die Antworten von 4.5, fügt jedoch auch hinzu, dass dies möglicherweise nur auffällt, wenn man sich intensiv mit der Struktur und dem Inhalt der Antworten beschäftigt.

AI-Peanuts Blindprobe: GPT-4.5 vs. 4o

Wir führen hier auch eine Blindprobe der beiden Modelle durch - und zwar auf Deutsch, was für die Modelle ja auch immer noch mal eine andere Dimension ist. Schaut euch die Ergebnisse im Vergleich an und wählt aus, welche Antwort ihr präferiert. Die Auflösung folgt in der nächsten Ausgabe:

https://forms.gle/MWGKw4TosGosy4kx8

So eindeutig zu beantworten, wie gut der Allgemeinheit die Antworten des neuen Modells gefallen, und ob es die Versprechen der angeblich höheren emotionalen Intelligenz erfüllt, scheint also noch nicht möglich zu sein. Jedoch gab es zugegebenermaßen bei vorherigen Model-Releases ähnliche anfängliche Zweifel. Es bleibt noch abzuwarten.

Wofür kann 4.5 eingesetzt werden?

Basierend auf den beschriebenen Fähigkeiten - für welche Art der Aufgaben ist 4.5 dann das Richtige Modell? So ganz genau scheint selbst OpenAI das noch nicht zu wissen: “We’re still exploring what it’s capable of and are eager to see how people use it in ways we might not have expected.”

4.5 ist aktuell in ChatGPT nur für Pro Nutzer ($200/Monat) nutzbar, mit dem klaren Hinweis, dass es sich um eine “Research Preview” handle. Per API kann man das Modell auch nutzen, allerdings zu wahnsinnig hohen Kosten von $75/Million Input Token / $150/Million Output Token (vgl. mit z.B. $2.50 bzw. $10 für GPT 4o).

Die Kosten deuten darauf hin, dass das Modell für OpenAI aktuell auch im Betrieb extrem teuer ist. Sollte sich bewahrheiten, dass das Modell zwar für geschulte Augen bessere Ergebnisse liefert, für den Durchschnittsnutzer aber nicht, könnte es durchaus sein, dass 4.5 nicht zum neuen Standardmodell in ChatGPT wird, sondern eher ein Spezialmodell für ganz spezifische Aufgaben (die sich allerdings anscheinend noch nicht herauskristallisiert haben).

Fazit

GPT-4.5 ist ein weiterer Schritt auf der Achse des allgemeinen Fähigkeitszuwachses von großen Sprachmodellen. Nur sind die dazu gewonnenen Fähigkeiten diesmal zumindest noch nicht so plakativ erkennbar, wie das zum Beispiel bei mathematischen oder Coding-Fähigkeiten der Fall ist.

Die mögliche negative Auslegung des Releases ist, dass OpenAI sich nach den Nachrichten um Grok3 und Claude 3.7 im Zugzwang sah, auch etwas auf den Markt zu bringen, auch wenn man dafür eigentlich noch nicht in der Position war.

Eine mögliche positive Auslegung ist, dass auf dem Weg zu einer “AGI”, wie man das auch immer definieren mag, nicht nur Mathe- und Coding-Fähigkeiten von Bedeutung sein werden, sondern auch Bereiche wie Empathie und die eben erwähnte emotionale Intelligenz eine große Rolle spielen werden. Auch wenn das möglicherweise nicht so plakativ sichtbar ist, könnte 4.5 hier ein durchaus großer Schritt sein.

Spannend zu beobachten sein wird, ob und wie Reasoning Modelle, die auf GPT-4.5 basieren, einen klareren Fähigkeitssprung darstellen werden - wie nützlich ist das breitere Verständnis der allgemeinen Realität in Kombination mit komplexeren Denkprozessen?

Vielleicht ist ja beides wahr - 4.5 wurde verfrüht veröffentlicht, weil sich OpenAI im Zugzwang sah, aber in der nächsten Ausbaustufe als Basis für neue Reasoning Modelle kann es seine Stärken erst richtig zeigen. Ein Indiz dafür ist, dass das Modell anscheinend in einem komplexen Benchmark, der sozial-strategische Verhaltensmuster testet, als aktuelles Top-Modell abschneidet.

Hierauf werden wir in der Beobachtung der zukünftigen Modelle von OpenAI auf jeden Fall ein besonderes Augenmerk legen.

🛠 Trai it out:

Realistische Unterhaltungen mit einer KI führen

Sprach-Interfaces für KI sind schon seit einer Weile ziemlich weit oben im Hype-Cycle. Aber selbst die beeindruckendsten Tools wie u.a. ChatGPT Advanced Voice Mode oder auch die Grok App fühlen sich immer noch nicht so wirklich natürlich an. Auch wenn die Stimmen schon extrem realistisch sind, ist die leichte Verzögerung im Gespräch oft zu lang und die hörbare Emotion und Tonalität hört sich dann doch irgendwie “programmiert” an.

Heute zeigen wir euch eine interaktive Demo, die ihr ausprobieren könnt, die uns ziemlich stark beeindruckt hat:

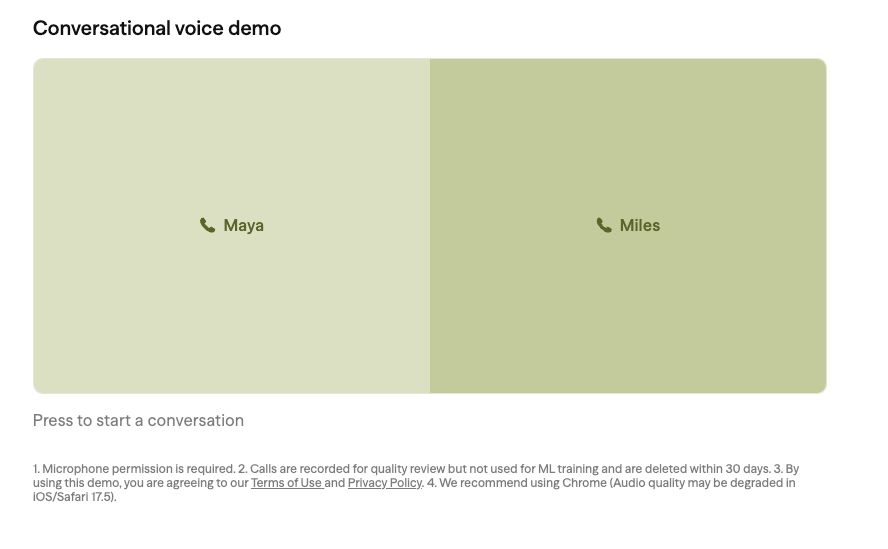

Das Startup Sesame stellt die neusten Ergebnisse ihrer Forschung vor und lässt uns interaktiv mit zwei Charakteren sprechen. Viel dazu sagen muss man eigentlich nicht - probiert es einfach mal aus und fragt euch, ob ihr das ohne Kontext direkt als KI erkennen würdet. Wichtig: Aktuell funktioniert das Ganze vor allem auf Englisch, man kann Deutsch ausprobieren, so richtig klappt das aber nicht.

Um die Demo auszuprobieren:

Wählt dann durch Click auf Maya oder Miles einen der beiden Charaktere aus

Wenn euer Browser euch dazu auffordert, gebt den Zugriff auf’s Mikrofon frei

Spannende Demos:

Tools kurz & knackig:

🍭🍬 Gemischte Tüte

🇪🇺 EU-News:

👩💻 Tech-News:

OpenAI erweitert sein Deep Research-Feature für alle zahlenden ChatGPT-Nutzer. Bisher nur für Pro-Abonnenten verfügbar, können jetzt auch Plus-, Team-, Edu- und Enterprise-Nutzer darauf zugreifen. Das Feature bietet tiefgehende Analysen, benötigt aber bis zu 30 Minuten pro Anfrage. Link

Einer unserer Lieblingsanalysten, Ben Evans, analysiert OpenAIs Deep Research. Er meint: „Eigentlich genau das Tool, das ich brauche – aber es bricht an den spannendsten Stellen zusammen.“ Link

Google-Gründer Sergey Brin, offiziell nur noch Google-Vorstandsmitglied, ist seit zwei Jahren wieder stark in der KI-Entwicklung involviert. Nun hat er ein internes Manifest veröffentlicht: „Hört auf, Produkte für Nannys zu bauen“, „Das Rennen zu AGI läuft“, und – ganz wichtig – alle sollen mindestens fünf Tage pro Woche im Büro arbeiten und 60 Stunden die Woche arbeiten. Link

ElevenLabs bringt mit Scribe eine neue Speech-to-Text-KI, die angeblich die höchste Genauigkeit weltweit erreicht – besser als Googles Gemini 2.0 Flash und OpenAIs Whisper v3. Sie erkennt 99 Sprachen und kostet 0,40 $ pro Stunde transkribierter Audioaufnahme. Hand hoch wer noch per Hand transkribiert hat? RIP Transkriptionspedal! Link

Anthropic plant eine neue Finanzierungsrunde über 3,5 Milliarden US-Dollar und steigt auf eine Bewertung von 61,5 Milliarden US-Dollar. Zeitgleich startet Perplexity einen 50-Millionen-Dollar-Fonds für Frühphasen-AI-Startups. Link

Es wird immer klarer, dass OpenAI seine Infrastruktur weg von Microsoft und hin zu Softbank verschiebt – egal ob das nun offiziell „Project Stargate“ heißt oder nicht. Link

Meta hat große Pläne: 2025 soll $60-65 Milliarden in Rechenzentren investiert werden, langfristig will man sogar hunderte Milliarden ausgeben. Jetzt wird über einen 200-Milliarden-Dollar-Campus diskutiert. Link

Der chinesische Smartphone-Hersteller Honor kündigt eine 10-Milliarden-Dollar-Investition in KI-Geräte an. Link

Microsoft bringt mit Phi-4 eine neue Generation kompakter KI-Modelle an den Start – hohe Leistung bei wenig Ressourcenverbrauch. Link

DeepSeek behauptet, „theoretische“ Gewinnmargen von 545 % zu erreichen – klingt extrem optimistisch. Link

Zuerst beschweren… dann kopieren! Immer mehr KI-Unternehmen setzen auf Destillation, um günstigere, effizientere Modelle zu bauen – also Modelle aus bestehenden großen Systemen „herauszukochen“. Link

Meta überlegt, eine eigenständige KI-App zu launchen. Bisher sind ihre Modelle tief in Apps wie Instagram und WhatsApp versteckt – aber vielleicht ist es Zeit für ein eigenes Icon auf dem Homescreen? Link

Bain hat Daten dazu gesammelt, wie viele Nutzer „Zero-Click“-Suchen verwenden – also Suchanfragen, die keine Klicks mehr auf externe Seiten generieren. Die große Frage bleibt: Wie sieht SEO in einer Welt mit LLMs aus? Link

Ethan Mollick erklärt die drei zentralen Entwicklungswege für KI: Pre-Training (Skalierung), Post-Training (Feinjustierung) und besseres logisches Denken. Jedes Unternehmen setzt aktuell andere Prioritäten. Link

Ein Data Center auf dem Mond? Ja, wirklich. Lonestar und Phison haben ein erstes Mini-Rechenzentrum per SpaceX-Rakete ins All geschickt. Ziel ist es, Daten außerhalb der Erde zu speichern – ein völlig neuer Ansatz für Datensicherheit. Link

NVIDIA hat im letzten Quartal beeindruckende 39,3 Milliarden Dollar Umsatz gemacht – ein Plus von 78 % im Vergleich zum Vorjahr. Besonders stark: das Data-Center-Geschäft mit 35,6 Milliarden. Und sie erwarten fürs nächste Quartal sogar 43 Milliarden! Link

👷 Work & Future of Work:

Eine Studie des Brookings Institute analysiert, wie generative KI verschiedene Regionen und Arbeitsmärkte beeinflussen könnte – und warum sich dieser Wandel von bisherigen technologischen Umwälzungen unterscheidet. Link

Ed Zitron liefert eine harte Analyse zur aktuellen wirtschaftlichen Lage im KI-Sektor und stellt die Nachhaltigkeit der Geschäftsmodelle infrage. Link

Daron Acemoglu, Nobelpreisträger in Wirtschaft (Sonderpreis muss man wohl dazu sagen), warnt davor, dass der aktuelle KI-Trend zu stark auf Automatisierung setzt und zu wenig auf Systeme, die Menschen unterstützen. Link

92 % der britischen Studierenden nutzen KI für ihre Schul- und Uni-Aufgaben. Der Anteil ist über die letzten Jahre rasant gestiegen – viele Unis fragen sich nun, was das für Prüfungen und Leistungsbewertung bedeutet. Link

Jeder dritte Arbeitnehmer macht sich Sorgen, dass KI auf lange Sicht Jobchancen verringert. Link

🆕 Neue Anwendungsfelder:

Ein neues Startup namens Mark hat einen KI-gestützten Lesezeichen-Tracker entwickelt. Er merkt sich, wo du aufgehört hast zu lesen, fasst Kapitel zusammen und teilt Highlights mit Freunden. Video dazu gibt es hier. Link

Perplexity verbessert seinen Voice-Modus, der jetzt noch schneller ist und längere, dynamische Gespräche über beliebige Themen ermöglicht – inklusive Echtzeit-News aus dem Netz. Link

🔐 Cybersecurity & AI Safety:

🏥 Health & Education:

Salesforce bringt eine Bibliothek mit vorgefertigten KI-Tools für den Gesundheitssektor heraus. Link

KI erkennt Darmkrebs mit hoher Genauigkeit – ein Durchbruch in der Früherkennung. Link

Chinas erster KI-Kardiologe entlastet das überfüllte Gesundheitswesen in Shanghai. Link

Anthropic startet eine Kooperation mit den US National Labs für die erste „1.000-Scientist-AI-Jam“ – eine groß angelegte Initiative zur Erforschung von KI für wissenschaftliche Zwecke. Link

🖼️ Kreativindustrie:

Meta und OpenAI lassen ihre KI-Modelle von Journalisten trainieren. Eine neue Untersuchung zeigt, wie Redakteure eingesetzt werden, um den KIs bessere Quellen und Kontexte beizubringen. Link

OpenAI will den Sora-Videogenerator in ChatGPT integrieren – damit wird Video-Generierung für noch mehr Nutzer direkt zugänglich. Link

Pika 2.2 ist da – mit 10-Sekunden-Videogeneration, besseren Übergängen und einer Funktion, die Objekte komplett verwandeln kann. Link

Activision gibt zu, dass sie KI-generierte Assets in Call of Duty: Black Ops 6 verwenden – nach massiver Kritik durch die Community. Link

AI Peanuts Workbook

Vollgepackt mit KI-Wissen, Tools & Tutorials!

Du hast angefangen, dich tiefer mit dem Thema KI zu beschäftigen und willst den nächsten Schritt machen? Dann ist unser offizielles AI Peanuts Workbook genau das Richtige für dich!

Das Workbook ist kein klassisches “Buch”, sondern ein praxisorientiertes, interaktives digitales Dokument. Gegliedert in 3 Teile:

Theorie — Der Textbuch-Teil des Workbooks, in dem wir das Thema KI und seine technischen Grundlagen erklären.

Praxis — Eine Reihe von praktischen Tutorials, mit denen du lernst, KI praktisch anzuwenden (z.B.: ChatGPT Masterprompts, HeyGen, NotebookLM, Midjourney…)

Daten — Datenbanken mit den besten KI-Tools und den spannendsten Firmen im KI-Umfeld.

🧂 Salty Memes:

Du hast Fragen, Anmerkungen oder brauchst unsere Hilfe?

Schreib uns einfach an:

[email protected]

Willkommen!

Hat dir das ein Freund oder eine Kollegin geschickt? Melde dich an und erhalte 2x Woche deine eigene Ausgabe mit den wichtigsten KI News direkt in dein Postfach.

Bis Freitag!