Endlich ist es soweit. Der große OpenAI DevDay hat stattgefunden. Mit dabei war zwar nicht AGI aber immerhin die kleinen iterativen Schritte die irgendwo dazwischenliegen. Das ganze Event war gerade mal 45 Minuten lang und schrie förmlich nach Apple Keynote. Sam Altman sagte mal dass es ihm in seinem Leben nur einmal die Sprache verschlagen hat und zwar als er Steve Jobs begegnete. Zum Glück trägt Sam keinen Schwarzen Rollkragen, stattdessen war es n Khaki Pullover. 45 Minuten sind nicht lang, wenn ihr es euch selbst angucken möchtet, dann findet ihr unten im Artikel den Link zum ganzen Video. So jetzt gehen wir aber Schritt für Schritt die wichtigsten Ankündigungen durch. Hier eine kleine Agenda für euch:

🤝 Microsoft x OpenAI: ‘The best partnership in Tech’

💡 GPT-4 Turbo API: ‘So outdated wird GPT nie wieder’

💰️ Das Highlight: CustomGPTs für dich, andere & for-sale

🤝 Microsoft x OpenAI: ‘The best partnership in Tech’

Gleich zu Beginn der Show holt Sam Altman erstmal Satya Nadella, den CEO von Microsoft, auf die Bühne. Da wurde natürlich erstmal Tacheles geredet! Satya, ganz der Charmeur, macht direkt klar: "We love you guys" – also alles tutti zwischen Microsoft und OpenAI? Man munkelte ja, dass es zwischen OpenAI und Microsoft kriseln könnte, und diesen Gerüchten wollten sie von Beginn an ein Ende setzen.

Aber man fragt sich schon: War Microsoft von Anfang an erste Wahl für OpenAI, oder gab es vielleicht einen kleinen Flirtversuch mit Apple, der danebenging? Wie auch immer, Microsoft ist jetzt am Start und Satya steht voll hinter der Sache. Er beschreibt eindringlich wie groß der Einfluss von GPT auf Microsofts Strategie ist: Alle Azure Rechenzentren, von der Energiezufuhr bis hin zum Serverrack, werden auf die Bedürfnisse der Modelle hin entworfen.

Satya betonte noch, dass Microsoft selbst ja auch ganz schön fleißig mit GPT arbeitet. Mit GitHub Copilot zum Beispiel zeigen sie, was man mit OpenAIs APIs so alles anstellen kann.

Zum Schluss kommt Satya noch mit einem kleinen Zukunftsausblick um die Ecke. Er ist sehr zuversichtlich und möchte Microsoft an der Spitze der Tech-Welle halten, damit OpenAI weiter in der KI-Welt herumexperimentieren kann. Ist damit das Gerede von einer kriselnden Beziehung zwischen Microsoft und OpenAI vom Tisch? Sieht ganz so aus, zumindest fürs Erste. Sam nannte es: ‘The best Partnership in Tech’ – das lässt hoffen.

💡 GPT-4 Turbo API: ‘So outdated wird GPT nie wieder’

So und jetzt kommen wir langsam zum Eingemachten. Zunächst ging es um Verbesserungen bei der API, und im Zuge dessen wurde auch ein neues Modell vorgestellt. Nein… leider noch nicht GPT-5, aber jetzt schön strukturiert die einzelnen Punkte:

Keine Modelleinstellungen mehr: Bisher musste man in ChatGPT oben einstellen, welches Modell man nutzen möchte. Da man sowieso immer das stärkste Modell einstellen wollte und nie so recht wusste, wann man Browsing oder CodeInterpreter gebrauchen könnte, ist das nun vorbei. ChatGPT weiß von nun an selbst, welches Modell es nutzen soll.

GPT-4 Turbo: So heißt das neue Modell, das speziell für die Bedürfnisse von Entwicklern konzipiert wurde. Altman hat versprochen, dass OpenAI nie wieder so "outdated" sein wird wie mit dem alten Wissensstand von 2021. Das neue Kontextfenster ist jetzt auf April 2023 gesetzt. Außerdem wurde die Kontextlänge auf bis zu 128.000 Tokens erweitert – das sind umgerechnet etwa 300 Buchseiten.

Mehr Kontrolle über Antworten: Neue Funktionen wie ‘JSON Load’ wurden eingeführt, um die Antwort des Modells genauer steuern zu können. Entwickler können nun beispielsweise sicherstellen, dass die Antworten des Modells als gültiges JSON-Format ausgegeben werden.

Verbesserte Weltkenntnisse: Das neue GPT-4 Turbo ist nicht nur auf dem neuesten Stand, sondern auch schlauer in Bezug auf die Integration externer Informationen. Die verbesserte Retrieval-Funktion eröffnet neue Möglichkeiten, externe Wissensquellen einzubinden.

Neue Modalitäten: OpenAI packt DALL•E 3 und GPT-4 Turbo mit Bildverarbeitung in die API. Mit dabei ist ein verbessertes Text-to-Speech-Modell namens WhisperV3. Es ist also besser darin, Sprache zu verstehen, hat sechs individuelle Stimmen, mit denen GPT antworten kann, und die Interaktion soll um einiges flüssiger laufen

💰 Das Highlight: CustomGPTs für dich, andere & for-sale

Das war das absolute Highlight des DevDay. Sam stellte klar, in welche Richtung sich OpenAI entwickeln will. Im Fokus stehen Agents, also KI-Assistenten, die sukzessive entwickelt werden, um eines Tages umfangreiche Aufgaben eigenständig zu erfüllen. Wie das aussehen wird? Völlig unklar – wir hoffen einfach nicht, dass es aussieht wie in diesem Video hier (😀). Sam betonte, dass diese Entwicklung viel Arbeit und viele kleine Schritte erfordert. Der erste Schritt wird bald veröffentlicht, ein genaues Datum steht jedoch noch aus.

Custom GPTs: OpenAI benennt damit die maßgeschneiderten GPT-Varianten, die bald jeder erstellen kann. Diese individuellen GPTs sind für spezifische Anwendungsfälle konzipiert, entweder für den persönlichen Gebrauch oder zur Weitergabe an andere. Statt generischer Beispielfragen in ChatGPT sind Custom GPTs bereits mit einer klaren Aufgabe und möglichen Fragestellungen vertraut und können auf hochgeladene Dokumente Bezug nehmen. Sie kombinieren Anweisungen, erweitertes Wissen und Aktionen, wodurch sie sich für viel mehr Zwecke eignen. Ich könnte zum Beispiel ein GPT machen, dass sich ausschließlich damit beschäftigt StandUp-Comedy Sets zu erarbeiten. Ich formuliere das Ziel, füge Dokumente/Blogs/Bücher hinzu die Inhalte liefern die berücksichtigt werden sollen und schärfe mit der Zeit ein GPT, dass herausragend darin ist Comedy-Sets zu schreiben. Und zwar nur das.

Das klingt zunächst etwas vage, aber im Grunde löst OpenAI damit sein bisheriges Plug-In-Konzept ab und ersetzt es durch CustomGPTs. Ein Anwendungsbeispiel ist Canva: Hier kann man ein Designprojekt textlich formulieren und es dann in Canva fertigstellen – eine deutliche Verbesserung gegenüber den früheren Plug-Ins. Dank persistenter Threads, eingebauter Retrieval-Funktionen, Code-Interpreter und verbesserter Funktionsaufrufe ist im Prinzip alles möglich. So kann man beispielsweise mit Zapier seinen Kalender in ChatGPT integrieren und Slack-Nachrichten verschicken, teils von ganz allein, wenn etwas bestimmtes passiert ist – also beispielsweise ich einen Kalenderinvite bekommen habe. Spannend hierbei: In der Demo wurde der Kalender und Slack über ChatGPT angesteuert - OpenAI versucht sich hier wie ein Betriebssystem vor alle Apps zu schalten.

GPT-API: Diese CustomGPTs funktionieren auch als API, was bedeutet, dass man sie in eigenen Apps oder Webseiten integrieren kann. Welche Anwendungsfälle sich daraus entwickeln? Kein Schimmer! Aber spannend ist es.

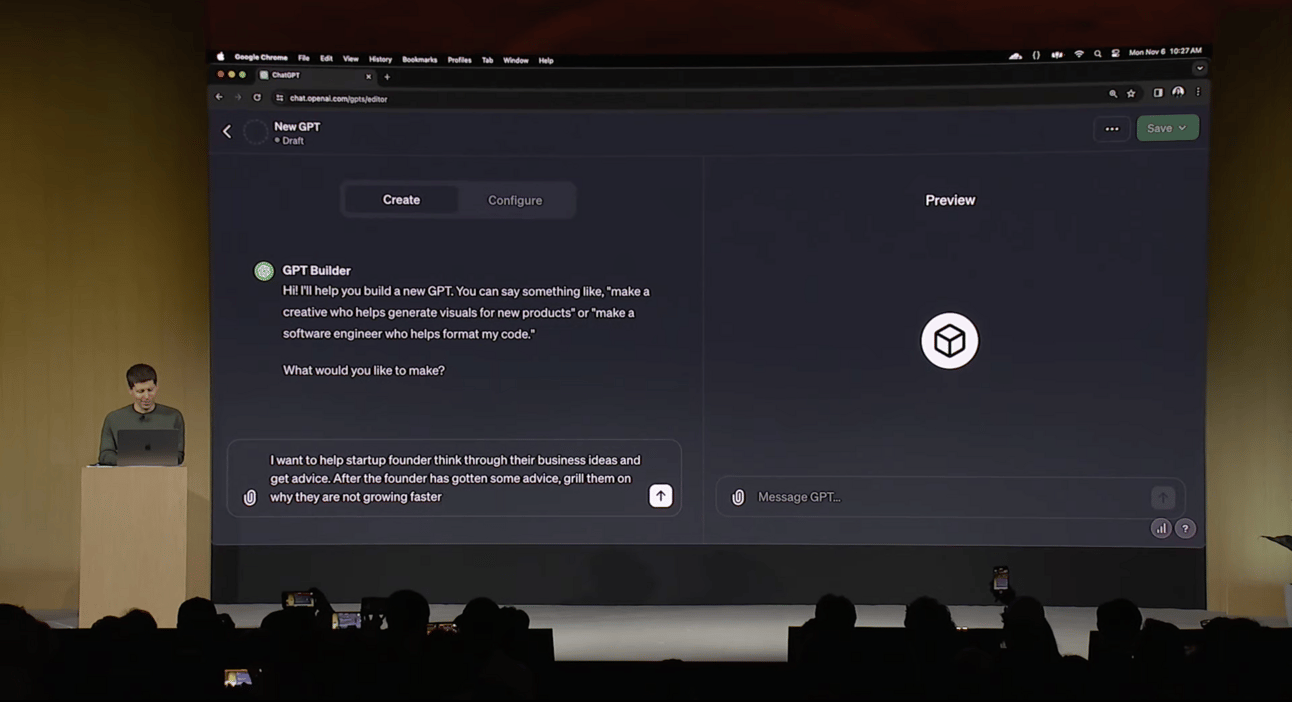

GPT-Store: Das war für uns ein ganz besonderer Moment bei dem Event. Ein eigenes GPT zu erstellen, ist super. Aber wirklich Beeindruckend ist, dass man dazu nicht mal programmieren können muss. Man kann ein CustomGPT allein durch Spracheingabe aufsetzen und verfeinern, verschiedene Dokumente und Bücher hochladen und es entweder allein nutzen oder mit anderen teilen. Und mit anderen teilen? Wo soll man das machen? Dafür gibt es einen GPT-Store. Dort hat man Zugang zu GPTs anderer Nutzer und kann seine eigenen mit anderen teilen und sie verkaufen. Ein bisschen wie bei Notion-Templates.

Noch spannender ist der Revenueshare: Das Erstellen von GPTs könnte zu einem echten Beruf werden, bei dem man spezifische GPTs für konkrete Anwendungsfälle entwickelt, die vielen Menschen nützen, kann man damit Geld verdienen – OpenAI beteiligt die Creator an den Umsätzen. Wie viel und ob das tatsächlich angenommen wird, wird sich zeigen, aber die Möglichkeit ist definitiv faszinierend.

So…nächstes Jahr findet der nächste OpenAI DevDay statt, bei dem sich diese Ankündigungen vielleicht völlig veraltet anfühlen. Diese Industrie bewegt sich schneller als man es je für möglich gehalten hat. Wenn du bis hierhin gelesen hast, dann erstmal an großes Danke. Wir bleiben weiter dran bis…ja mindestens bis der Peanuts-CustomGPT uns ersetzt. Bis dahin, bleiben wir euch erhalten! Cheers & danke fürs lesen!